دیپفیک (Deepfake) چیست و چگونه میتواند تهدیدی برای حقیقت باشد؟

در عصر اطلاعات، جایی که ویدئوها و تصاویر نقش اصلی در انتقال مفاهیم، اخبار و احساسات ایفا میکنند، ظهور فناوریهایی که واقعیت را دستکاری میکنند، میتواند نتایجی خطرناک در پی داشته باشد. یکی از برجستهترین این فناوریها، دیپفیک (Deepfake) است؛ ترکیبی از “یادگیری عمیق” (Deep Learning) و “جعلی بودن” (Fake) که به کمک آن، تصاویر، صدا و ویدئوهایی کاملاً قانعکننده اما نادرست تولید میشود.

در ابتدا، دیپفیک بیشتر جنبه سرگرمی داشت، اما بهمرور، کاربردهای منفی و سوءاستفاده از آن در حوزههایی مانند سیاست، اخبار جعلی، آزار اینترنتی و حتی جعل هویت، زنگ خطر جدی را برای جهان فناوری، رسانه و امنیت به صدا درآورده است.

دیپفیک چگونه کار میکند؟

دیپفیک از الگوریتمهای شبکه عصبی مصنوعی و بهویژه شبکههای مولد تخاصمی (GANs) استفاده میکند. این الگوریتمها به سیستم کمک میکنند تا از طریق یادگیری دادههای زیاد (مثل هزاران تصویر یا ویدئو از یک شخص)، بتواند محتوایی جعلی و تقریباً غیرقابلتشخیص از واقعیت تولید کند.

بهعنوان مثال:

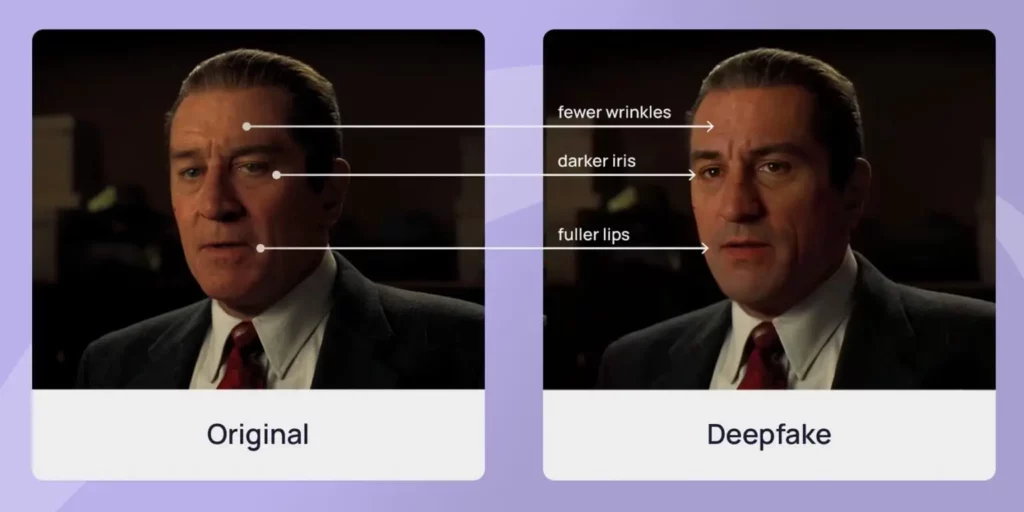

- در ویدئوهای دیپفیک تصویری، چهره فردی بر بدن فرد دیگر جایگذاری میشود.

- در دیپفیک صوتی، صدای فرد با دقت بسیار بالا تقلید میشود تا بتوان جملاتی را به او نسبت داد که هرگز نگفته است.

کاربردهای مثبت دیپفیک

با اینکه دیپفیک بیشتر به دلیل کاربردهای منفیاش مشهور شده، اما استفادههای مفید و اخلاقی نیز دارد:

- سینما و تولید محتوا

در صنعت فیلمسازی، از دیپفیک برای بازسازی چهره بازیگران فوتشده، جوانسازی چهرهها یا دوبله چهرهمحور استفاده میشود. - آموزش و مستندها

با استفاده از دیپفیک، میتوان بازسازیهای واقعگرایانهای از شخصیتهای تاریخی ایجاد کرد که به آموزش تاریخ و علوم کمک میکند. - ابزارهای دسترسپذیری (Accessibility)

تولید ویدئوهایی با حرکات لب هماهنگ برای افراد ناشنوا یا ترجمه آنی ویدئوها با چهرههای واقعی.

تهدیدهای دیپفیک

در کنار کاربردهای مفید، دیپفیک به دلایلی به یکی از نگرانیهای اصلی در حوزه امنیت سایبری، رسانه و حقوق بشر تبدیل شده است.

۱. جعل سیاسی و انتشار اخبار دروغین

تصور کنید ویدئویی از یک رهبر سیاسی منتشر شود که در آن به جنگ یا اقدامات تحریکآمیز تهدید میکند. چنین ویدئویی اگر حتی چند ساعت قبل از انتخابات یا تصمیمگیری دیپلماتیک منتشر شود، میتواند فاجعهبار باشد.

مثالهای متعدد از این نوع در سالهای اخیر دیده شده است، از جمله ویدئوهای جعلی از باراک اوباما یا ولادیمیر زلنسکی.

۲. آزار و سوءاستفاده شخصی

یکی از شایعترین مصادیق دیپفیک، استفاده از چهره افراد در محتوای نامناسب است. این نوع سوءاستفادههای دیجیتال منجر به آسیبهای روانی، شهرتی و حتی تهدیدهای امنیتی برای قربانیان شدهاند.

۳. سرقت هویت و کلاهبرداری

هکرها با استفاده از دیپفیک صوتی میتوانند با تقلید صدای مدیر یک شرکت، کارمندان را فریب داده و از آنها اطلاعات حساس یا انتقال پول درخواست کنند. در چندین مورد واقعی، چنین کلاهبرداریهایی موفقیتآمیز بودهاند.

۴. تضعیف اعتماد به رسانهها

حتی اگر یک ویدئوی دیپفیک جعلی شناخته شود، همینکه شک و تردید درباره صحت رسانهها ایجاد شود، به اعتماد عمومی آسیب میزند. در آینده ممکن است افراد برای فرار از مسئولیت بگویند: «این ویدئو دیپفیک است» حتی اگر واقعی باشد.

تشخیص دیپفیک؛ آیا هنوز ممکن است؟

تشخیص دیپفیک روزبهروز سختتر میشود، اما هنوز راهکارهایی برای شناسایی آن وجود دارد:

- بررسیهای فنی

ابزارهایی طراحی شدهاند که با بررسی تغییرات نور، حرکت چشم، هماهنگی صدا و چهره، یا بافت پوست، احتمال جعلی بودن ویدئو را مشخص میکنند. - هوش مصنوعی برای مبارزه با خود دیپفیک

بسیاری از پژوهشگران در حال طراحی الگوریتمهایی هستند که دقیقاً مانند دیپفیک آموزش دیدهاند اما در جهت معکوس: برای شناسایی و افشای آن. - روشهای متادیتا و رمزنگاری

برخی شرکتها به دنبال راهحلهایی هستند که ویدئوهای واقعی را با امضای دیجیتال منتشر کنند تا اصالت آنها در آینده قابل بررسی باشد.

تلاش جهانی برای مقابله با دیپفیک

برخی کشورها و سازمانهای بینالمللی شروع به قانونگذاری در زمینه دیپفیک کردهاند:

- قوانین ایالتی در آمریکا: برخی ایالتها، تولید دیپفیک با هدف آسیب سیاسی را جرمانگاری کردهاند.

- اتحادیه اروپا: در قانون جدید هوش مصنوعی (AI Act)، الزامات سختگیرانهای برای تولیدکنندگان محتوای مصنوعی وضع شده است.

- پلتفرمهای اجتماعی: یوتیوب، فیسبوک و تیکتاک سیاستهایی برای حذف محتوای دیپفیک گمراهکننده تدوین کردهاند، اما اجرای آن هنوز کامل نیست.

مسئولیت کاربران و رسانهها

در دنیایی که جعل تصویر و ویدئو به این سادگی ممکن است، ما بهعنوان کاربران باید:

- منبع محتوا را بررسی کنیم

هر ویدئو یا تصویری را بلافاصله باور نکنیم؛ از منابع معتبر پیگیری کنیم. - به رسانههای مستقل و حرفهای اعتماد کنیم

رسانههایی که اعتبار و سابقه دارند، به احتمال بیشتر صحت مطالب را بررسی کردهاند. - سواد دیجیتال داشته باشیم

مهارتهای تشخیص محتوای جعلی را یاد بگیریم و به دیگران آموزش دهیم.

دیپفیک یک فناوری قدرتمند و دو لبه است. از یک سو، میتواند محتوای خلاقانه، آموزشی و کاربردی تولید کند؛ از سوی دیگر، اگر بدون نظارت و قانونگذاری رها شود، میتواند بنیان اعتماد اجتماعی، سیاسی و انسانی را به چالش بکشد. آینده برخورد با دیپفیک، نیازمند ترکیبی از آموزش، تکنولوژی تشخیص، قوانین شفاف و آگاهی عمومی است.

سایر مطالب مرتبط: